本文转载自:至顶网计算频道

近日,AMD举行2022年金融分析师日活动,在活动中公司高管表示,AMD拥有适合的芯片和软件在更广泛的AI领域开拓疆土。

过去几年AMD在数据中心重新站稳脚跟之后,如今希望通过扩展芯片组合覆盖从边缘到云的所有方面,成为AI计算领域的一个重要参与者。

这是一个相当雄心勃勃的目标,特别是眼下Nvidia凭借GPU和CUDA编程模型在该领域占据主导地位,还有来自英特尔和其他几家厂商越来越激烈的竞争。

近日,AMD举行2022年金融分析师日活动,在活动中公司高管表示,AMD拥有适合的芯片和软件在更广泛的AI领域开拓疆土。

AMD首席执行官Lisa Su在开场白中表示:“我们的愿景是提供广泛的技术路线图,覆盖涉及到云、边缘和端点的训练和推理领域,我们能够做到这一点,是因为我们已经涉足到所有这些市场并拥有所有相关产品。”

她坦言,AMD想要在AI领域迎头赶上还“需要做很多工作”,但她表示,这个市场对AMD来说是“最大的一个增长机会”。

在AI推理领域延续CPU的优势

AMD高管在这次活动上表示,他们已经开始看到AI计算市场开始引入AMD的产品,Epyc服务器芯片用于推理应用,Instinct数据中心GPU用于AI模型训练。

AMD Epyc业务负责人Dan McNamara表示,多家云服务提供商已经通过AMD ZenDNN(Zen Deep Neural Network)库使用AMD的软件优化功能,为使用AMD Epyc CPU的推荐引擎上实现了“非常出色的性能提升”。

ZenDNN集成了主流的TensorFlow和PyTorch框架以及ONNXRT,并得到第二代和第三代Epyc芯片的支持。

他说:“我认为,在CPU中运行大部分推理,这一点是非常重要的,我们预计未来这种趋势会持续下去。”

AMD希望不久将来,在硬件层面上把更多的AI功能引入CPU中,其中包括AVX-512 VNNI指令,今年晚些时候AMD将把该指令引入下一代Epyc 芯片(代号Genoa)中用于加速神经网络处理。

由于该功能是在Genoa Zen 4架构中实施的,因此VNNI也将出现在AMD Ryzen 7000桌面芯片中,该芯片将于今年年底面市。

此外,AMD计划利用此前490亿美元收购(今年早些时候完成)来的FPGA设计公司赛灵思的AI引擎技术,来扩展未来AMD CPU的AI功能。

这些构建块将出现在AMD产品组合中的下一代芯片中

这个名为XDNA系列“自适应架构”构建块系列下的AI引擎,未来将被引入AMD产品组合中的多个新产品中。

AMD在2018年第一次将该AI架构用于赛灵思Versal自适应芯片中,接下来AMD将把它集成到未来两代的Ryzen笔记本电脑芯片中,第一款芯片代号为Phoenix Point,将于2023年面市,第二款芯片代号为Strix Point,将于2024年面市,此外也将用于下一代Epyc服务器芯片中,不过AMD没有透露具体时间。

AMD预计将于2024年推出首款使用下一代Zen 5架构的芯片,其中包含了针对AI和机器学习工作负载的新优化功能。

借助“第一个数据中心APU”在AI训练领域实现自己的雄心目标

至于GPU,AMD凭借最新一代的Instinct GPU MI200系列在AI训练领域取得了一些进展,希望在不久的将来通过推出新的芯片和软件增强取得更大的进展。

例如,AMD在最新版本的ROCm GPU计算软件中,针对运行在PyTorch和TensorFlow等框架上的训练和推理工作负载进行了优化。

AMD GPU业务负责人David Wang表示,AMD还将把ROCm扩展到使用RDNA架构的、以消费者为中心的Radeon GPU中。

“最后,我们正在开发带有预优化模型的SDK,用于简化AI应用的开发和部署。”

他表示,为了推动AMD GPU在AI领域被采用,AMD已经“与业内一些主要的领导厂商建立了深厚的合作伙伴关系”,其中包括微软和Facebook母公司Meta。

“我们针对PyTorch优化了ROCm,在他们的内部AI工作负载以及联合开发的开源基准测试中,实现了惊人的、非常有竞争力的性能表现。”

展望未来,AMD希望通过号称“全球第一个数据中心APU”——Instinct MI300在AI训练领域变得更有竞争力,该芯片结合了基于Zen 4的Epyc CPU以及采用AMD GPU CDNA 3架构的GPU。

AMD声称,与目前市场上的Instinct MI250X芯片相比,Instinct MI300的AI训练性能有望提高8倍多。

AMD数据中心解决方案业务部负责人Forrest Norrod表示:“MI300是一款真正令人惊叹的产品,我们相信,它指明了未来加速的方向。”

利用赛灵思向边缘扩张以及改进软件

尽管AMD计划在未来的CPU中使用赛灵思的技术,但也明确表示,这次收购还将帮助AMD在AI领域获得更广泛的机会,以及加强自己的软件产品——如果AMD想要更好地与Nvidia等厂商竞争,这一点至关重要。

这是赛灵思前首席执行官Victor Peng提出的,他现在是AMD自适应和嵌入式事业部的负责人,该事业部主要负责赛灵思产品组合中所有基于FPGA的产品的开发。

在今年年初完成收购赛灵思之前,AMD在AI计算领域覆盖的范围主要是云数据中心的Epyc和Instinct芯片,企业级的Epyc和Ryzen pro芯片,以及家庭用的Ryzen和Radeon芯片。

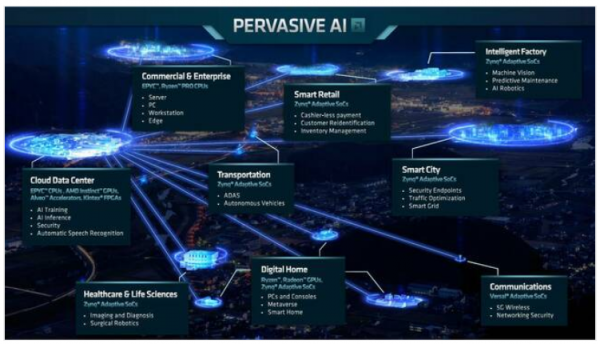

但随着赛灵思的产品组合被收归于AMD旗下,AMD扩大了在AI市场的覆盖范围,因为赛灵思的Zynq自适应芯片应用于多个行业,包括医疗和生命科学、交通运输、智能零售、智慧城市和智能工厂。另一方面,赛灵思的Versal自适应芯片被电信提供商采用,以及用于云数据中心的Alveo加速器和Kintex FPGA。

AMD通过收购赛灵思,将产品覆盖到AI计算领域的多个行业

Peng表示:“我们在很多领域都在做AI,主要是推理,负载密集型训练主要运行在云端。”

AMD认为,赛灵思的产品与AMD的CPU和GPU产品组合是“非常互补的”,因此,AMD的目标是针对广泛的AI应用需求提供组合产品:

Ryzen和Epyc CPU,包括未来支持AI引擎的Ryzen CPU,涵盖用于训练和推理的中小模型;

支持AI引擎的Epyc GPU、Radeon GPU和Versal芯片,涵盖用于训练和推理的中大模型;

Instinct GPU和赛灵思的自适应芯片,涵盖用于训练和推理的超大模型。

Peng说:“一旦我们开始将AI集成到更多的产品中,并且进化到下一代,不同模型就会覆盖更多的领域。”

AMD CPU、GPU和自适应芯片可覆盖到的AI应用领域

但如果AMD想要更广泛的行业采用其芯片用于AI,那就需要确保开发人员能够轻松地在在AMD芯片上编写应用。

这就是为什么AMD计划把此前用于CPU、GPU和自适应芯片的不同软件堆栈整合到一个接口的理由,AMD称其“AMD Unified AI Stack”。第一个版本将整合AMD用于GPU编程的ROCm软件、CPU软件和赛灵思的Vitis AI软件,为推理工作负载提供统一的开发和部署工具。

Peng表示,AMD将持续开发Unified AI Stack,也就是说,AMD计划在未来整合更多的软件组件,例如,让开发者不管是任何一种类型的芯片都只需要使用一个机器学习图形编译器。

他说:“现在开发人员可以在相同的开发环境中使用任何一个目标架构,我们将在下一代整合更多的中间件。”

AMD制定了一项雄心勃勃的AI计算战略,但无疑需要开发人员进行大量繁重的工作,并且AMD也要采取适当的措施才能让这一战略发挥作用。