针对 5G 蜂窝和机器学习 DNN/CNN 等计算密集型应用,赛灵思的新型矢量处理器 AI 引擎由 VLIW SIMD 高性能处理器阵列构成,与传统的可编程逻辑解决方案相比,功耗减半,芯片计算密度提升高达 8 倍。

迎来 AI 引擎

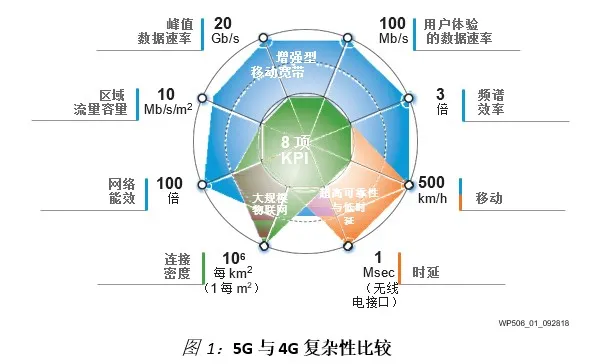

多项技术的发展正在促使对更高非线性计算密度的需求。随着 5G 技术的发展,大规模 MIMO、多天线、多频带等新技术所导致的复杂性比 4G 高百倍。不断提高的复杂性直接推高计算密度、存储器要求和 RF 数据转换器性能。

为满足新一代无线通信应用和机器学习应用对提高计算密度、降低功耗水平的需求的迅猛增长,赛灵思开始研发创新型架构,最终开发出 AI 引擎。AI 引擎结合自适应引擎(可编程逻辑)和标量引擎(处理器子系统),构成紧密集成的异构计算平台。AI 引擎为基于矢量的算法带来了高达五倍的计算密度提升。自适应引擎提供灵活的定制计算和数据传输。

AI 引擎目标

AI 引擎的目标由使用 DSP 和 AI/ML 的高计算强度应用决定。其他的市场需求还包括更高的开发者生产力、更高的抽象水平,这正在推动开发工具的演进发展。

AI 引擎的开发旨在提供四大优势:

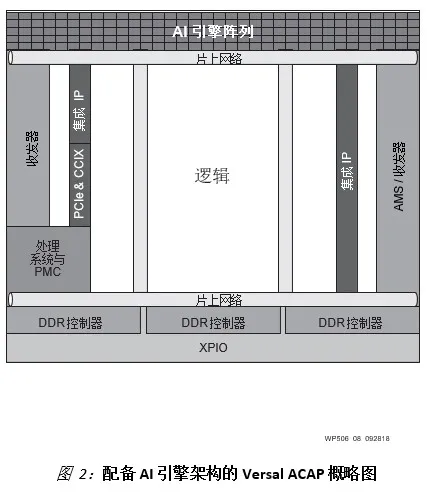

配备 AI 引擎架构的 Versal 产品组合概述

Versal 器件包括三种类型的可编程处理器:Arm® 处理器子系统 (PS)、可编程逻辑 (PL) 和 AI 引擎。每一种都提供不同的计算功能,以满足总体系统不同部分的需求。Arm 处理器一般用于控制平面应用、操作系统、通信接口和较低级别的运算或复数运算。PL 负责数据操作与传输、非矢量型计算和接口。AI 引擎一般用于矢量实现方案中的计算密集型功能。

AI 引擎应用

1. 使用 AI 引擎开展数字信号处理

实时 DSP 在无线通信中得到了广泛的应用。赛灵思通过比较经典窄带和宽带无线电设计原则、大规模 MIMO 以及基带和数字前端概念的实现方案,证明 AI 引擎架构适用于构建无线电解决方案。

2. 机器学习与 AI 引擎

在机器学习中,卷积神经网络 (CNN) 是一类深度前馈人工神经网络,最常用于分析视觉图像。随着计算机正在被广泛用于从自动驾驶汽车到视频监控直至图像和视频的数据中心分析等万事万物,CNN 已成为必备要素。CNN 提供的技术突破在于让视觉图像的可靠性和准确度足以用于安全地驾驶车辆。

CNN 技术目前处于初期阶段,几乎每个星期都有新突破涌现。这个领域的创新节奏令人惊叹。这意味在未来几年里就有望实现前所未有的全新应用。

然而,CNN 面临的挑战在于所需的高强度计算,通常需要数 TeraOPS。AI 引擎的优化正是为了低成本、高能效地实现这样的计算密度。

总结

AI 引擎是新一类高性能计算的代表。AI 引擎集成在 Versal 级别的器件中,能与 PL 和 PS 最优结合,在单个赛灵思 ACAP 中实现高度复杂的系统。实时系统需要确定性行为。对此 AI 引擎通过结合专用数据和编程存储器、DMA 与锁以及编译工具予以实现。

与传统的可编程逻辑 DSP 与 ML 实现方案相比,AI 引擎的单位芯片面积计算密度提高了 3-8 倍,同时在名义上降低功耗 50%。C/C++ 编程模式可提高抽象水平,有望大幅提升开发者的生产力。

从内置 30 个 AI 引擎和 8 万 LUT 的小型器件到内置 400 个 AI 引擎和近百万个 LUT 的大型器件,系统性能可扩展性通过系列器件得以实现。这些器件间封装脚位兼容,方便在产品系列内进行迁移,以满足不同的性能目标和价格目标要求。

更多详细方案与技术内容,请点击此处下载《赛灵思AI引擎及其应用》白皮书原文进行查看。