赛灵思近期推出重磅活动,2495 美元的优惠价购买用于 AI 推断的 VCK5000 Versal™ 开发卡,VCK5000 的计算能力比当前的服务器级 CPU 高 100 倍,MLPerf 推断性能也高于当前的服务器级 GPU,是云加速和边缘计算应用的理想开发平台。

VCK5000 Versal 开发卡搭载赛灵思 Versal 自适应计算加速平台 [ACAP]XCVC1902 器件,该器件采用台积电 7nm 技术制造,拥有 400 个以 1.25GHz 运行的 AI 引擎 [AIE],结合可编程逻辑 [PL]内的 1968 个 DSP 引擎结合,可提供高达145 TOPS [INT8] 的 AI 推断算力。此外,它还提供了大量片上存储器,可用来存储特征图或中间数据,从而进一步提高 AI 推断效率。

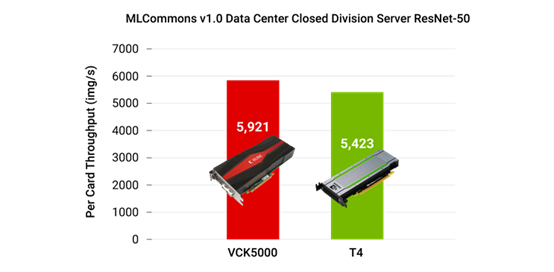

根据 MLCommons™ 近期发布的 MLPerf™ 推断 v1.0 测试结果,在服务器场景下, VCK5000 帮助 Resnet50 达到了 5,921fps 的性能;在数据中心封闭域的离线场景下,实现了 6,257fps 的性能。在相同的基准测试中,与英伟达的 T4 GPU 卡相比性能提高 9%,后者被广泛应用于数据中心和本地部署的 AI 推断。

Vitis™ AI 1.3.1 版完全支持 VCK5000,它有两种 DPU 变型 [AH1] ,分别采用 384 个和 288 个 AIE 内核。它可以从 Vitis AI Model Zoo 中为不同的分类、检测和分段任务 [AH2] 运行超过 50 种 AI 模型,其中包括 Resnet、Yolov3、SSD、Unet、Openpose、SalsaNext 等。

我们已经为 VCK5000 构建了两个演示,分别是用 BERT 进行自然语言处理和 MLPerf 1.0 Submission Resnet-50。您可以快速运行它们以查看性能结果,演示包可通过申请获得。

VCK5000 的 AI 性能可以随 DPU 使用的 AIE 内核数量进行扩展。根据您的 AI 应用的性能需求,它可以用相同的软件协议栈部署在云上或部署在本地。

为了更好的向开发者介绍VCK5000的详细内容和如何特惠价购买,赛灵思特邀请三位专家于05.23日进行 VCK5000 的技术分享:

如何在Alveo versal上快速部署AI推断 - VCK5000助力软件/AI开发升级

时间:2021.05.23 19:30-22:00

嘉宾一:《在 VCK5000 快速部署AI推断 - 实现100x CPU,1.1x GPU性能》

王宏强 (George Wang),赛灵思高级产品市场经理

演讲简介:

Xilinx®VCK5000 Versal 开发卡基于Xilinx 7nm VersalACAP架构构建,专为高吞吐量AI推理和高性能计算应用而设计。

VCK5000具有标准化的软件开发流程,可提供比当今服务器级CPU高100倍的计算能力,并且比当今服务器级GPU更好的MLPerf推理性能,是云加速和边缘计算应用的理想开发平台。Vitis5000 AI开发环境完全支持VCK5000,该开发环境包括优化的IP,工具,库,模型和示例设计。设计高效,易于使用。用户无需使用任何FPGA硬件知识,就可以在几分钟内使用Python或C ++ API运行Tensorflow,Pytorch,Caffe模型。

嘉宾二:《上手 VCK5000 升级AI开发》

罗霖 (Andy Luo),赛灵思公司机器学习产品营销高级经理

负责赛灵思产品在机器学习应用中的市场和业务拓展工作。他在半导体和嵌入式行业拥有 15 年的工作经验。在加入赛灵思之前, 他曾经在 ARM 和 Intel 从事嵌入式市场与软件业务开发工作。拥有复旦大学电子工程学士学位和通信工程硕士学位。

嘉宾三:《VCK5000硬件特性和部署》

覃祥菊 (Lily Qin) ,赛灵思数据中心 Alveo 技术支持资深工程师

摘要:VCK5000 硬件结构分析和部署建议