随着以人工智能技术为代表的数字经济浪潮的来临,如今,AI 正越来越多地被部署于边缘应用,这些应用要求以低时延、低功耗和小封装尺寸执行大量数据处理。

要想实现这一综合要求就必须为整体 AI 流程和非 AI 流程都进行提速,这也要求加速平台必须具备灵活应变的能力。在此背景下,赛灵思推出自适应 SOM为 AI 赋能边缘应用提供了更高效的解决方案。

想要抢先体验加速边缘创新的全新方式?

请点击下方视频

自适应 SOM,我们为您开箱讲解

是否还未尽兴?对 SOM 依然还有很多疑问?

6月10日,10:00-11:30

我们将举办 KRIA SOM 系列技术研讨会

从开发到上市

全面助力开发者迅速完成 AI 赋能的边缘创新

自适应 SOM 的研发思路

在构建一款 AI 赋能边缘应用的过程中可能会遇到大量可用的方案。在众多行业中,通用方法是硬件设计团队开展“芯片先定”的策略,尽管这种方法能切实提供高度优化的实现方案,但需要耗费大量开发时间与成本才能达到量产就绪状态。

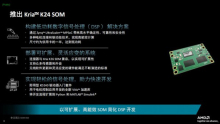

为节省研发支出和时间,赛灵思设计团队采用了集成度更高的解决方案,即自适应系统模块(SOM)。SOM 提供了一个完整的可量产化计算平台,与“芯片先定”开发相比,可节省大量开发时间和成本。此外,SOM 还能插入更大型的边缘应用中,既能为定制实现方案带来灵活性与易用性,又缩短了现成解决方案的上市时间。

自适应计算为 SOM 提供技术支持

对于 AI 赋能的边缘应用而言,自适应计算是最具前景的支持技术之一。自适应计算涵盖了一套综合全面的设计与运行时软件集,这些软件结合起来,造就了一款独特的自适应平台,在此之上可以开发高度灵活且高效的系统。

借助自适应计算,无需 ASIC 等定制芯片器件涉及的设计时间和前期成本就能实现 DSA,这便于为任何给定领域迅速开发灵活的、经优化的解决方案,包括 AI 赋能的边缘应用。此外,自适应计算允许为应用专门开发硬件,而且如果工作负载或标准发生演进,仍能根据需要灵活适应。

自适应 SOM 为开发者赋能

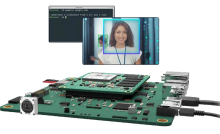

自适应 SOM 是一种面向边缘应用的理想平台,不论是对于硬件开发者还是软件开发者而言,它都拥有固定芯片技术的 SOM 所不能比拟的独特优势。

对于硬件开发者而言,适应 SOM 能够支持开发者使用现成的、可量产化的解决方案,从而省去大量的开发成本和时间。与典型“芯片先定”方式相比,基于 SOM 的设计可助力嵌入式视觉应用提前 9 个月完成。此外,自适应 SOM 还支持设计流程后期的修改设计。

对于软件开发者而言,自适应 SOM 可以在其熟悉的 Python、C++、TensorFlow 和 PyTorch 等环境下,为其提供易于使用、开箱即用的体验。除了预构建平台和 API ,综合全面的软件工具还能实现自适应硬件的完全定制,从而进一步提升灵活性和优化水平。

欲进一步了解自适应 SOM 时的独特优势,请扫描二维码报名并获取KRIA SOM 中文白皮书