作者:电子创新网张国斌

今天,在AMD "数据中心和人工智能技术首发式上,AMD发布了性能震撼的服务器和人工智能加速器新品,号将重塑未来计算推动下一代数据中心创新。

1、发布第四代AMD EPYC "Bergamo"

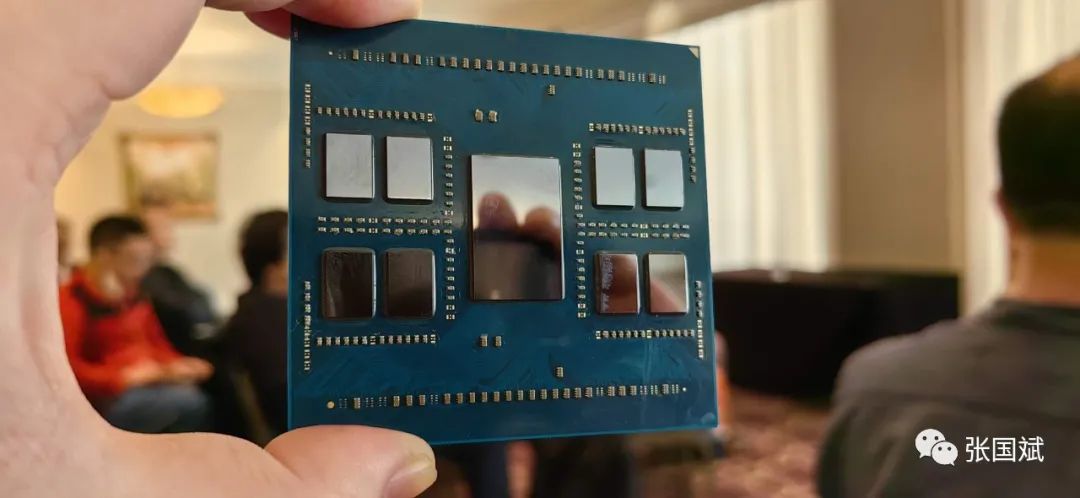

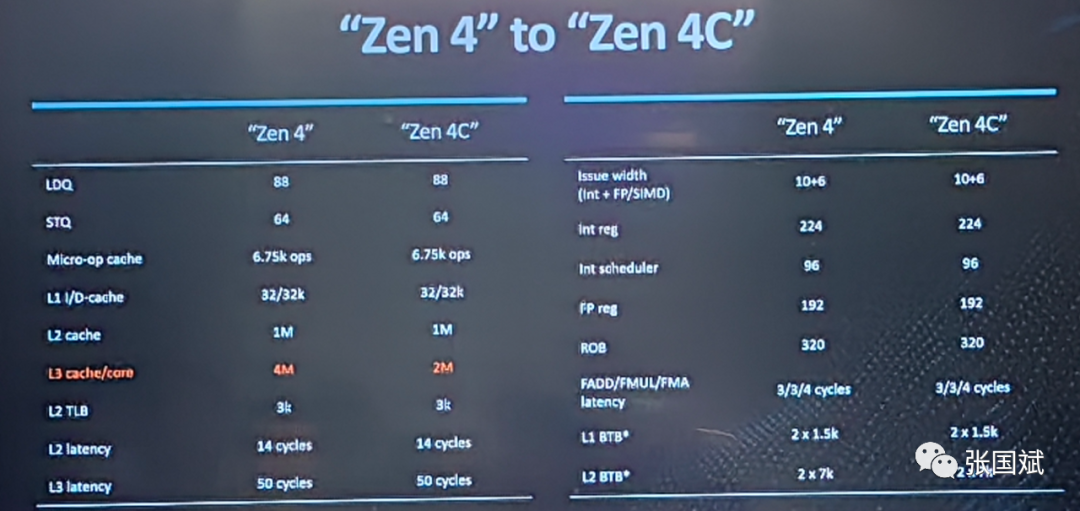

今天首先发布是AMD第四代AMD EPYC "Bergamo"。"Bergamo"有128个Zen 4c内核,瞄准云原生应用,Zen 4c内核是Zen 4优化后的内核,每个内核所需的面积减半,内核密度提升,它直接与英特尔至强服务器直接对标。

据介绍,它的核心+L3缓存面积为2.48mm平方毫米,比它在同一工艺节点上用标准Zen 4核心实现的3.84mm^2小35%。AMD采用了8个16核CCD,以达到128核的峰值核心数。

Bergamo采用5nm工艺有128个内核,可以放入服务器平台,配备 "Zen 4c "内核的第四代AMD EPYC处理器为客户提供了高达2.7倍的能效,并支持高达3倍的能效。Bergamo支持运行在DDR5-4800的12通道内存,AMD通过chiplet技术实现了这款高性能服务器芯片。

目前,AMD已经公布了两款Bergamo处理器,即128核/256线程的EPYC 9754,以及112核/224线程的EPYC 9734。后者每个CCD禁用两个核心。除了核心数之外,其余大部分规格都是一样的,所以9734仍然拥有每个CCX的16MB L3缓存和总共256MB L3缓存。AMD声称Bergamo芯片的能源效率提高了2.7倍。

2、第四代EPYC--96核AMD EPYC Genoa-X发布!

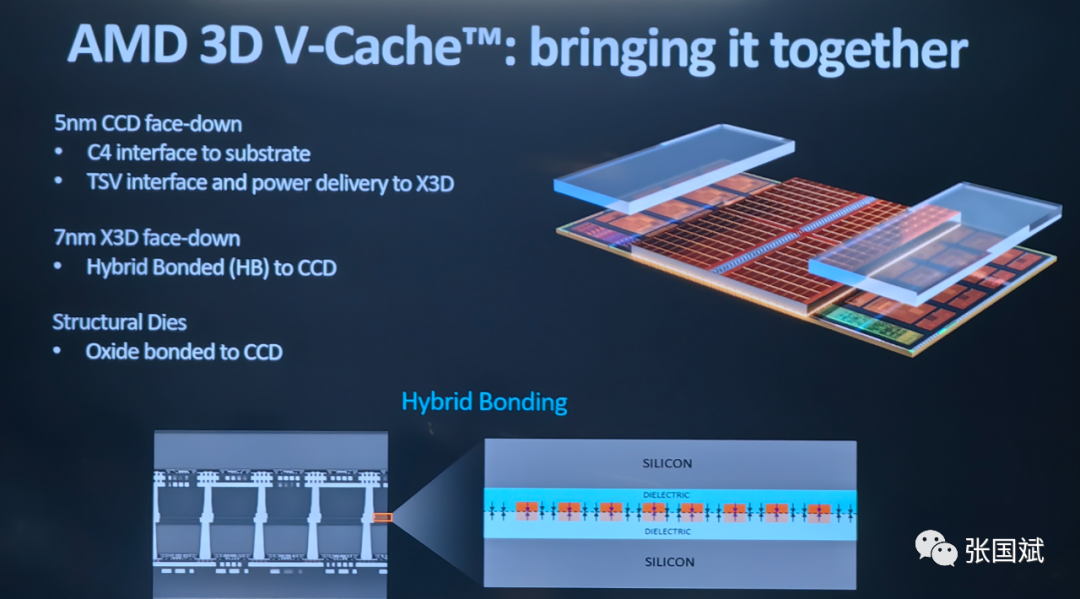

AMD今天还发布了Genoa-X EPYC 9084X系列,Genoa-X采用了3D V-Cache封装,在计算芯片上垂直融合了额外的64MB 7nm SRAM缓存,从而使每个芯片的L3缓存量增加了两倍。

Genoa-X系列和Genoa系列一样都是最多96个Zen4核心与384MB原生三级缓存,分为12个CCD,也就是每个CCD上自带32MB三级缓存。不同之处在于,Genoa-X在每个CCD上额外堆叠了64MB 3D缓存,12个CCD就是768MB,这样总的三级缓存就达到了1152MB,也是处理器缓存史上第一次突破1GB的产品。

该款新品直接对标英特尔同类产品,苏妈还做了对比

Genoa-X将L3缓存提高到1.1GB,比上一代型号的768MB增加了43%。Genoa-X达到了96核模型的顶峰,比上一代的64核峰值有明显的增加。

AMD提供的基准测试显示,Genoa-X与英特尔的80核8490H Xeon进行了正面交锋,对比效果明显,并与英特尔Xeon的相同核数进行了比较,在各种技术工作负载中再次表现出明显性能提升。

Microsft在现场宣布,其Azure云已全面提供其带有Genoa-X的新HBv4和HX系列实例,以及新HBv3实例。Azure还提供了显示性能提升的基准,最高提升了5.7倍。

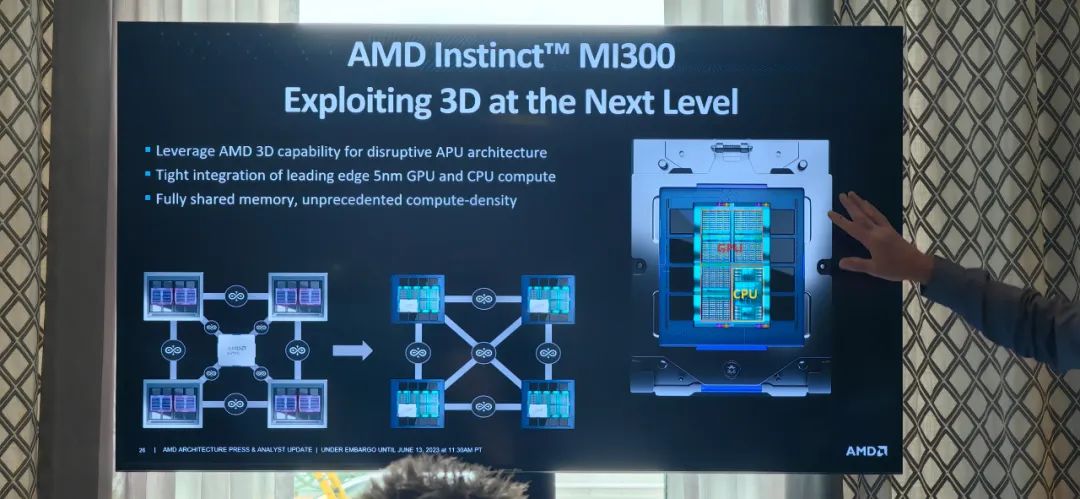

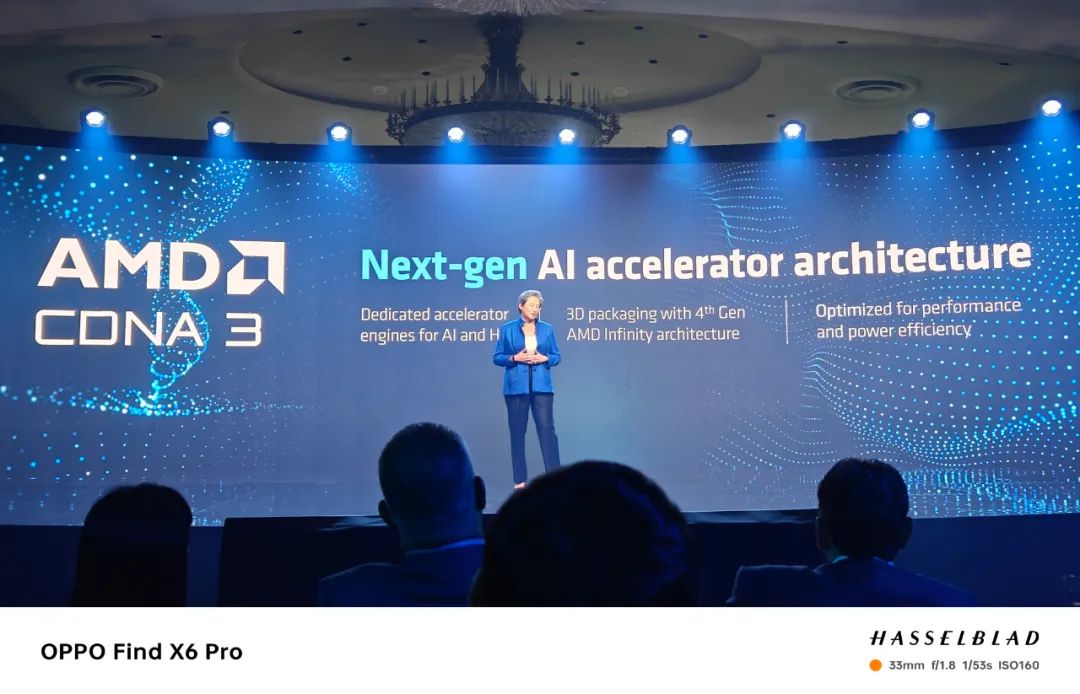

3、1530亿晶体管!支持800亿参数大模型!AMD发布MI300X GPU加速器

AMD在CES上曾经发布一款AI加速器Instinct MI300A,今天,在加州旧金山举行的数据中心和人工智能技术首发式上AMD分享了有关其Instinct MI300A处理器的更多细节,该处理器的特点是在同一封装上使用HBM的3D堆叠CPU和GPU核心,以及一个新的仅有GPU的MI300X模型,该模型将8个加速器放在一个平台上,拥有1.5TB HBM3内存。

在今年CES发布的Instinct MI300A是一个数据中心APU,它混合了总共13个芯片,其中许多是3D堆叠的,以创建一个单一的芯片包,其中有24个Zen 4 CPU核心,融合了CDNA 3图形引擎和八个堆叠的HBM3内存,总计128GB。该芯片有1460亿个晶体管,使其成为AMD已投入生产的最大芯片。九个计算芯片,混合了5纳米的CPU和GPU,在四个6纳米衬底芯片上进行3D堆叠。

今天,AMD还发布了一款Instinct MI300A的衍生版本--纯GPU的MI300X。它为大型语言模型(LLM)进行了优化,它搭配192GB HBM3内存。该芯片能够运行高达800亿个参数的大模型应用,AMD称这是单一GPU的记录。该芯片在八个通道上提供5.2TB/s的内存带宽和896GB/s的Infinity Fabric带宽。MI300X比Nvidia H100提供2.4倍的HBM密度,比H100提供1.6倍的HBM带宽,这意味着AMD可以比Nvidia的芯片运行更大的模型。

据AMD介绍,通过并行方式,将多颗MI300X级联可以支持更多参数运行!

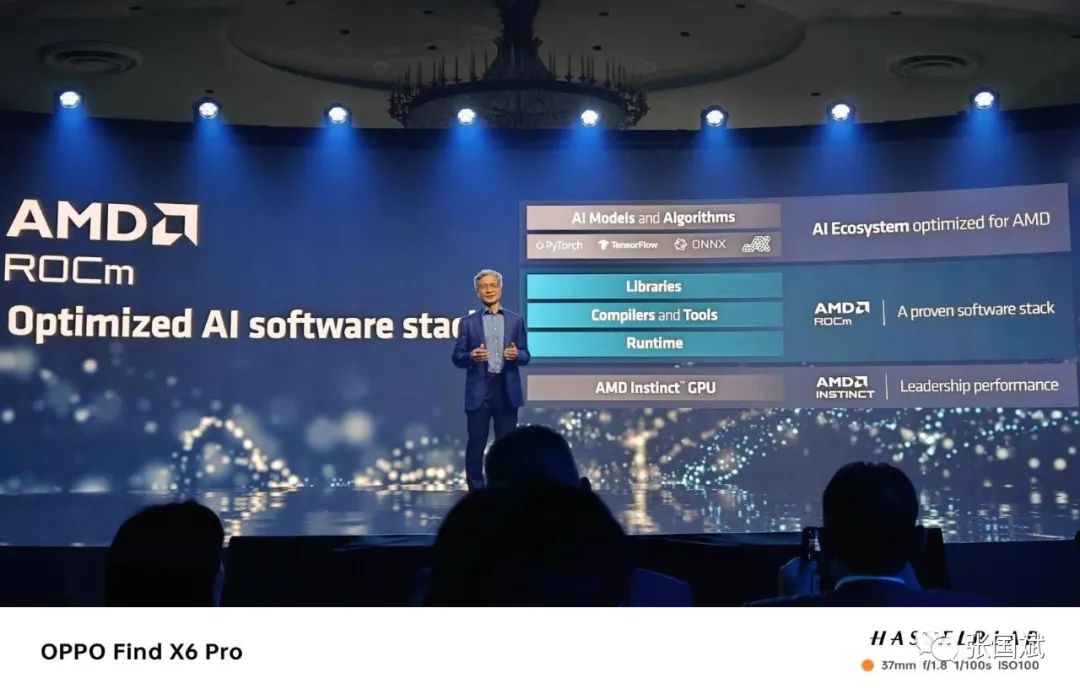

4、打造生态 ,推进AI应用

在今天的发布会上,AMD总裁Victor peng展示了用于数据中心加速器的ROCm™软件生态系统,强调了与行业领先者的合作,打造一个开放的AI 生态,这位赛灵思前CEO在赛灵思被AMD收购后担任了AMD总裁,负责AMD自适应和嵌入式产品,这次他介绍了AMD在AI方面的产品和生态布局。他还展示了用于数据中心加速器的ROCm™软件生态系统,强调了与行业领先者的合作,建立一个开放的AI生态。

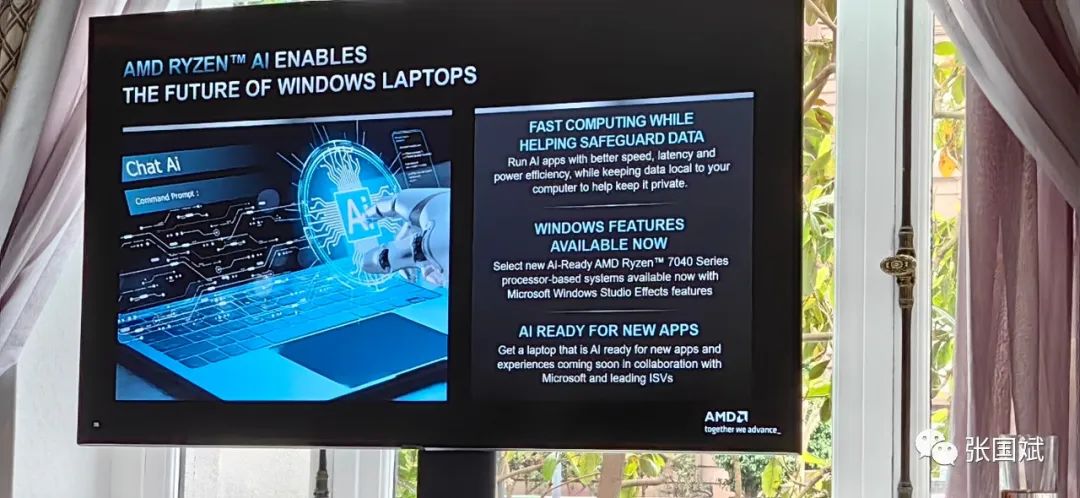

在会后的沟通中,AMD表示,未来用于笔记本的Ryzen系列处理器将全面导入AI能力,将大幅度提升笔记本的AI应用,AMD宣讲人表示未来的windows笔记本都将导入AI能力,形成CPU\GPU和AI相辅相成的方案,AMD提供基础算力而第三方合作伙伴提供开放的模型方便用户使用。

5、发布智能安全的DPU

今天,AMD还发布了下一代DPU,其目的是为客户带来更高的性能和能效。与目前这一代产品相比,它旨在为客户带来更高的性能和功率效率。产品,预计将于2023年底上市。

AMD还宣布了AMD Pensando硅中件开发工具包(SSDK),使客户能够快速开发或迁移。客户有能力快速开发或迁移服务,以部署在AMD Pensando P4可编程DPU上部署的服务,并与已在AMD Pensando平台上实现的现有丰富功能相协调。

据介绍,AMD Pensando DPU结合了强大的稳健的软件堆栈与 "零信任安全 "和领先的可编程数据包处理器相结合,创造出智能和先进的数据包,打造高度智能和性能的DPU。

亚马逊、微软、meta等合作伙伴,表达了要跟AMD继续深度合作的决心和意愿!