作者:新喀鸦,来源: TechWeb.com.cn

随着一些模型(例如大型语言模型)达到数万亿参数,AI、高性能计算和数据分析变得日益复杂。以英伟达为首的很多公司都推出了一系列用于AI计算的相关芯片。

而在近期美国加州圣何塞的AMD Advancing AI大会上,AMD正式公布了Instinct MI300系列加速器的详细规格与性能,以及众多的应用部署案例。那么AMD新发布的Instinct MI300到底怎么样?

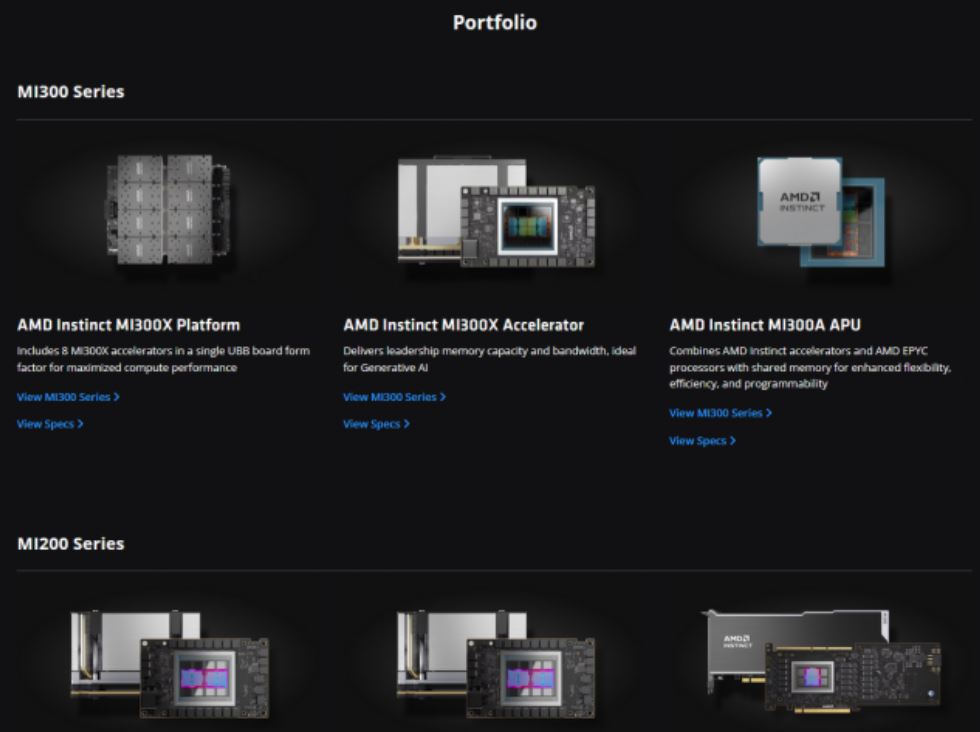

AMD Instinct MI300系列

MI300系列包含MI300A和MI300X两款产品,其中MI300A是集成了CPU+GPU的APU(Accelerated Processing Units)产品。MI300X则是采用了纯GPU设计的GPU产品。

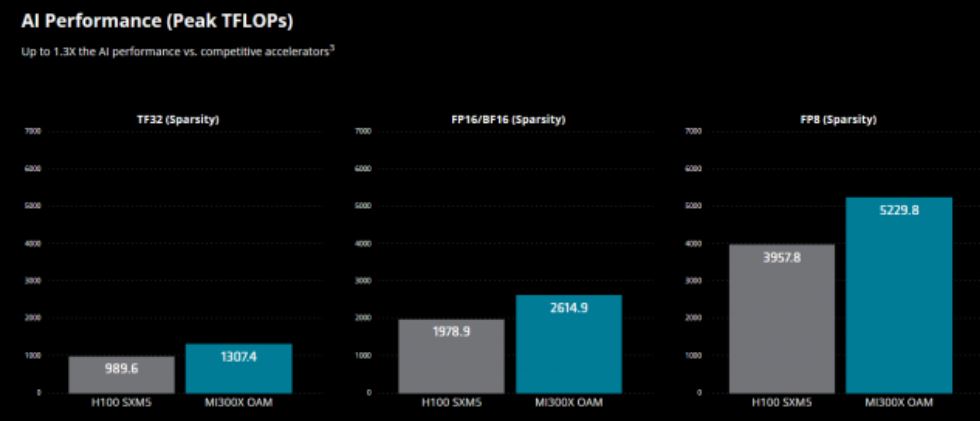

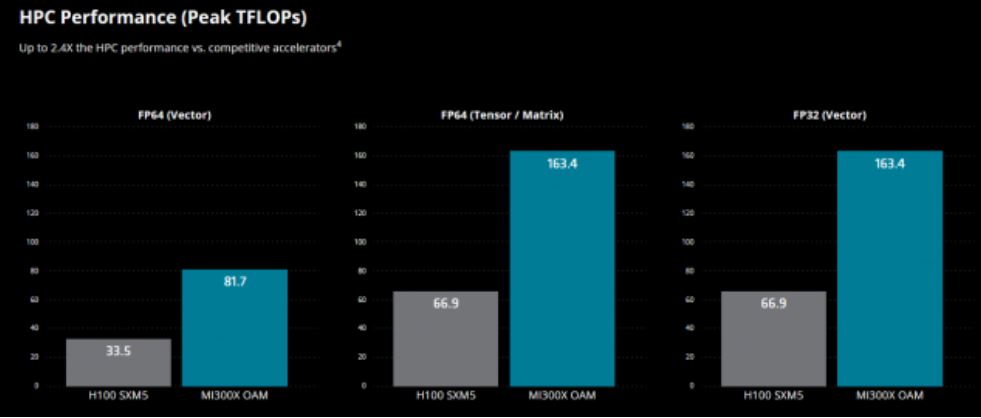

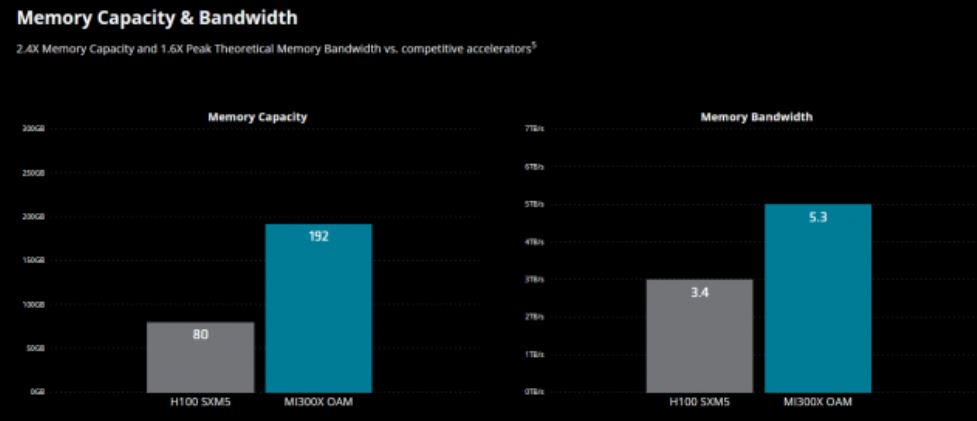

目前MI300系列在市场上的竞争对手无疑是英伟达的H100。在AMD官网上具体对比参数如下:

MI300A与H100相比,在AI算力方面两者几乎不分上下。

MI300A与H100相比,在高性能计算方面MI300A有着相对明显的优势。

MI300A与H100相比,在内存容量和带宽方面MI300A有着相对明显的优势。

MI300X与H100相比,在AI算力方面MI300X有着一定的优势。

MI300X与H100相比,在高性能计算方面MI300X有着相对明显的优势。

MI300A与H100相比,在内存容量和带宽方面MI300A有着相对明显的优势。

不过值得一提的是,MI300X有着304个CU(计算单元),而H100则只有132个SM(流式多处理器)。这样看来MI300X其实是靠“堆规格”把算力堆上去的。这就会造成在同样的成本下,算力方面H100比起MI300X更有优势。不过鉴于目前英伟达凭借各种优势把H100卖得很贵,AMD“堆规格”的策略也许是个不错的竞争方式。

ROCm 6

AMD在这次大会上还宣布将推出最新的AMD ROCm 6开放软件平台,不仅能提升AI加速性能,还增加了对生成式AI多项新功能的支持,包括FlashAttention、HIPGraph和vLLM等。

在生态系统层面,AMD的合作伙伴数量不断增加,除了Pytorch和Hugging Face外,OpenAI Triton 3.0版本也将支持AMD GPU。

AMD的软件生态圈ROCm(Radeon Open Compute Ecosystem)于2016年4月发布,相比2007年发布的英伟达CUDA起步较晚。因此目前从软件生态角度看,英伟达CUDA仍然具有相当的优势。

重要客户

根据目前的消息显示Meta、微软、甲骨文以及服务器供应商戴尔、惠普、联想、超微等将成为MI300系列的重要客户。这些公司的具体动向如下:

Meta正在新增AMD Instinct MI300X加速器至其数据中心。

微软近期发布Azure ND MI300x v5虚拟机(VM)系列产品。

甲骨文计划引入搭载AMD MI300X的裸机实例用于其高性能计算,且该基于MI300X的实例预计将支援配备高速RDMA网络的OCI Supercluster。

戴尔展示了Dell PowerEdge XE9680服务器,其配备8个MI300系列加速器。

惠普近期发布首款搭载AMD MI300A APU的超算加速器HPE Cray Supercomputing EX255a,预计于2024年上半年上市。

联想宣布计划将在2024年上半年推出基于AMD MI300系列加速器的创新设计。

超微推出基于第4代AMD EPYC处理器和AMD Instinct MI300系列加速器的H13系列新产品。

AMD中国官网

AMD美国官网

另外,目前在AMD中国官网AMD Instinct 加速器页面中还没有出现MI300系列的相关介绍,在“产品阵容”部分还是MI200系列的介绍信息。因此,MI300系列产品可能暂时不会向中国出售。