本文转载自: EDA365电子论坛微信公众号

Xilinx(赛灵思)于今年推出了全新的Vitis AI 2.0版本,更新了包括模型、软件工具、深度学习处理单元,以及最新的性能信息。

作为赛灵思 FPGA 和自适应 SoC 上最综合全面的基于软件的 AI 加速解决方案,2.0 版本的 Vitis AI 解决方案更易于开发者使用,给边缘和数据中心带来进一步的性能提升。

我们了解到,Vitis AI 2.0 版本更新了以下三个主要特性:

1. 易用性取得突破性进展

通过更好的CPU OP流程显著提升了模型覆盖率,同时支持了Tensorflow框架内推理机制。

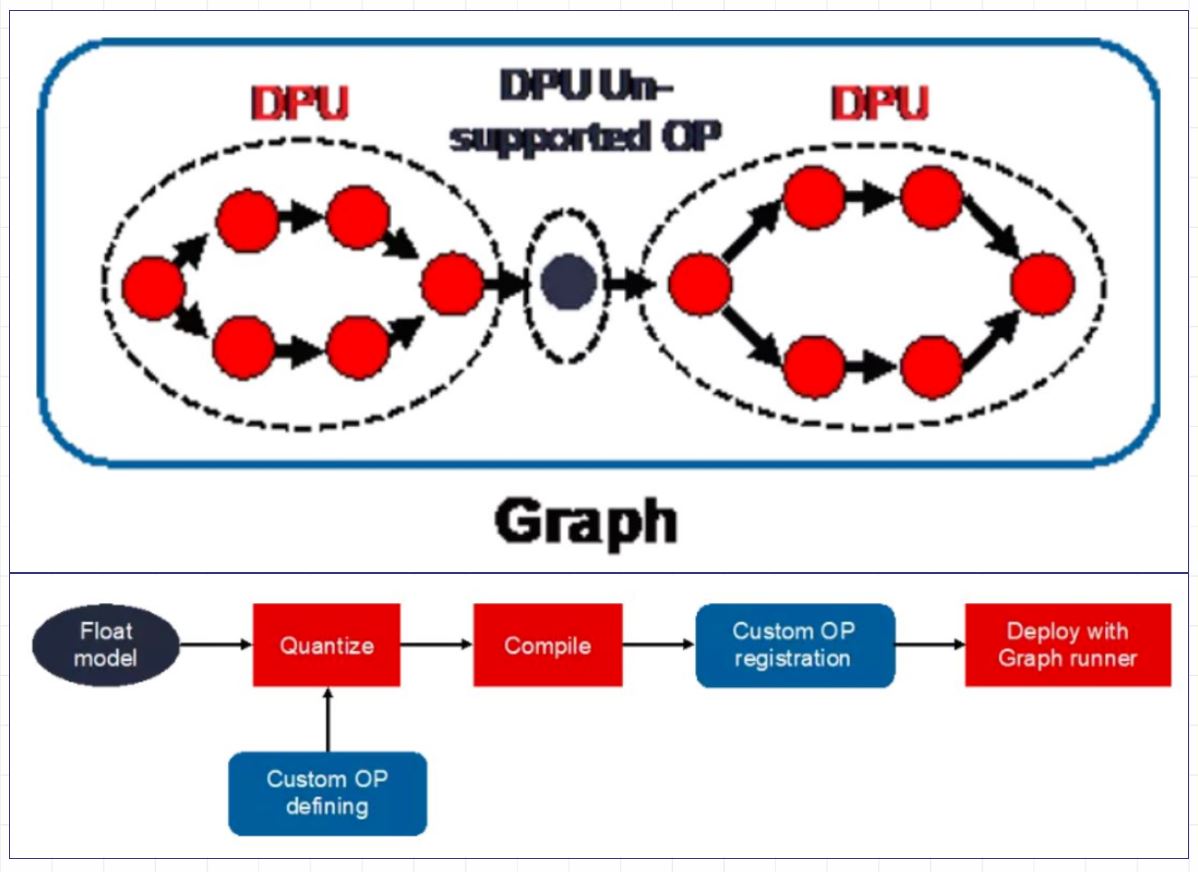

在 Vitis AI 2.0 中,自定义 OP 流程提供更简便的模型部署途径。

对于 DPU 不支持的 OP,在Graph Runner 对它们进行部署之前,通过量化流中定义这些 OP,用户可以轻松部署完整模型,不需要手动处理 DPU 和 CPU 之间的数据交换,避免在流程中出错。

2. 全新模型

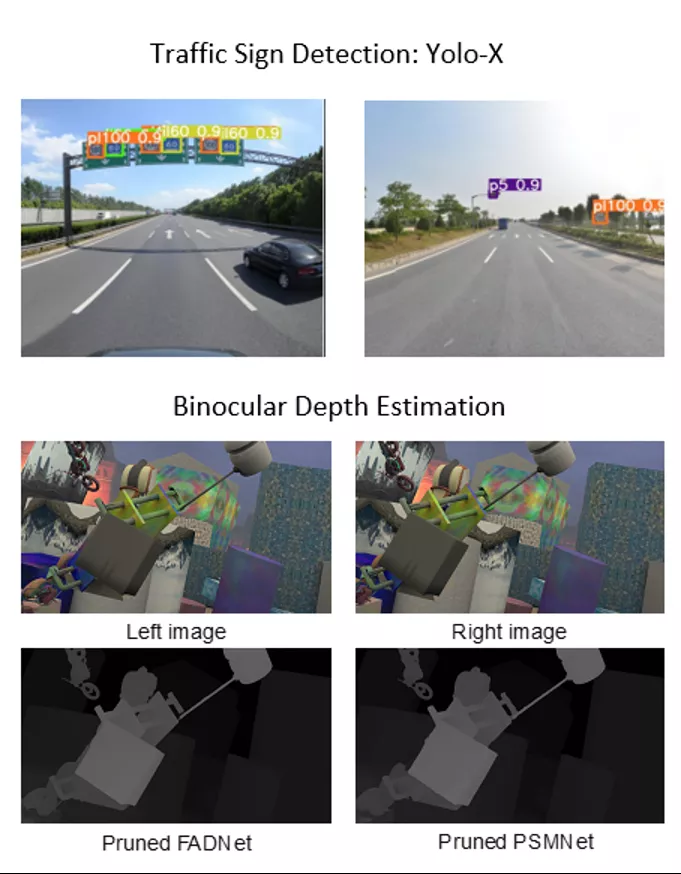

新增20个先进的 AI 模型,用于 CNN 和 NLP 中的传感器融合、视频分析、超分辨率和情感估计应用;

AI 模型库已成为 Vitis AI 堆栈中用户最常使用的组件之一。它提供了能够适用于多种视觉场景的免费、开放且可再训练的优化模型。

在 Vitis AI 2.0 版本中,免费模型的数量已增至 130 个,覆盖主流框架 Pytorch、Tensorflow、Tensorflow 2 和 Caffe 。除了这些经过训练的模型,新版本也提供了能够提高模型准确性与硬件性能的 OFA 搜索模型。

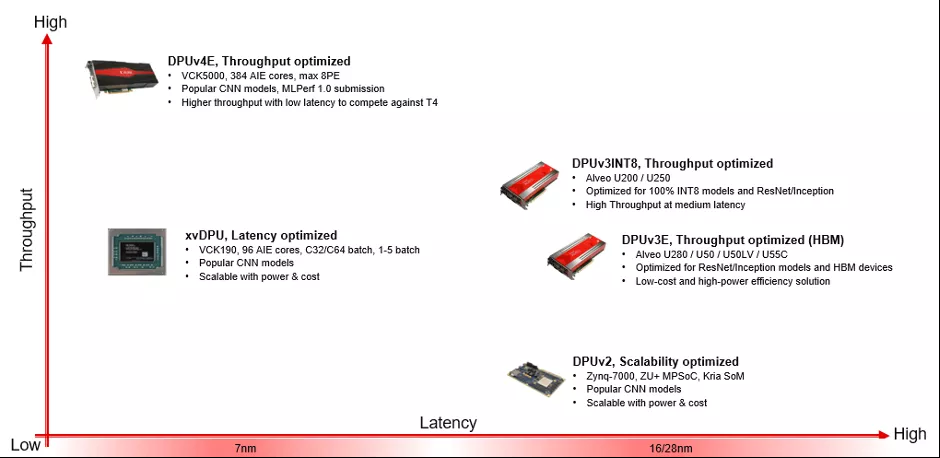

3. DPU 可扩展性和新硬件平台

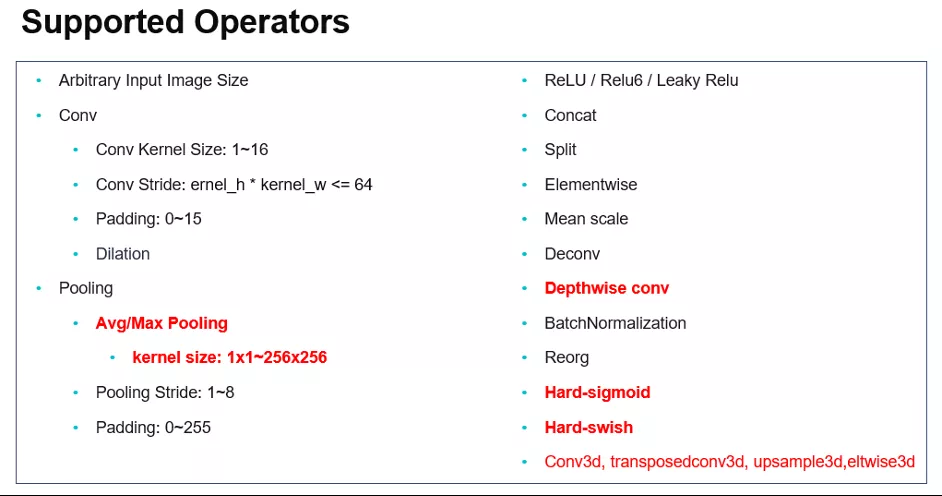

在 VCK190 和 VCK5000 硬件平台上提供了灵活的DPU IP配置及新功能,包括支持 3D 卷积、depthwise卷积等,可满足更多需求。

到目前,从嵌入式到数据中心,Vitis AI 全面支持所有主要的器件或加速器卡,包括 Zynq Ultrascale+ MPSoC、Versal ACPA 和 Alveo 卡。

除了上述新特性,赛灵思还改进了 Vitis AI 工具链的功能与性能,由此 AI 量化器与编译器均支持自定义 OP,且都支持更高版本的 Pytorch (v1.8-1.9) 、 Tensorflow (v2.4-2.6),同时AI 编译器、基于全新算法的Optimizer、AI Library、VART、AI Profiler和 WAA 都也支持本次发布的新增模型和自定义OP 流程。

赛灵思此次 Vitis AI 2.0 版本的发布,为用户的 AI 产品的价值提升做出了贡献,也加强了产品在市场中的竞争力。除以上三点特性之外,Vitis AI 2.0 版本还有更多的更新需要用户探索。

如果你想更全面的了解 Vitis AI 2.0 版本的优秀之处,电巢直播间本周三晚19:30,由赛灵思软件与AI产品市场经理Bingqing Guo(郭冰清)、软件与AI技术市场部资深工程师张帆、Aupera首席科学官(计算机视觉和机器学习)Ness (Narges) Afsham 博士,带来《Vitis AI 2.0助力加速您的AI之路》,不要忘记定好闹钟准时观看哦~