作者:姚颂,来源:Xilinx学术合作

2019年8月19日到21日,第31届Hot Chips大会在斯坦福大学成功举办。从2016年开始,这是我参加的第四届Hot Chips。在之前的三届Hot Chips,有两次我作为演讲者参与(2016年与2018年),有一年作为展商参与(2017年),这一次是第一次没有任何任务来参加Hot Chips,终于可以安心地听取报告、进行学习。而在之前Hot Chips TPC meeting刚结束时,已经从几位技术委员会的成员那里听说今年的竞争异常激烈,Xilinx的同事Ralph Wittig更是评论,这一届Hot Chips的论文质量是他觉得过去十年中最好的,让人不由得对本次Hot Chips充满期待。

本次大会确实是有非常多非常扎实的工作,也展现了整个处理器与高性能芯片领域行业的趋势与变化。本系列文章将介绍我在Hot Chips大会上的几点观察与思考,涵盖以下几点内容:

文章也将介绍一些Hot Chips会议上发生的趣事。由于内容十分之多,整个系列预计将分为(上)(中)(下)三篇分别刊出。未经特别说明,图片均来自于本人在Hot Chips拍摄的照片。

今天的(上)部分,就从大家最为关注的Cerebras开始说起

No.1:Cerebras:会议最大热点

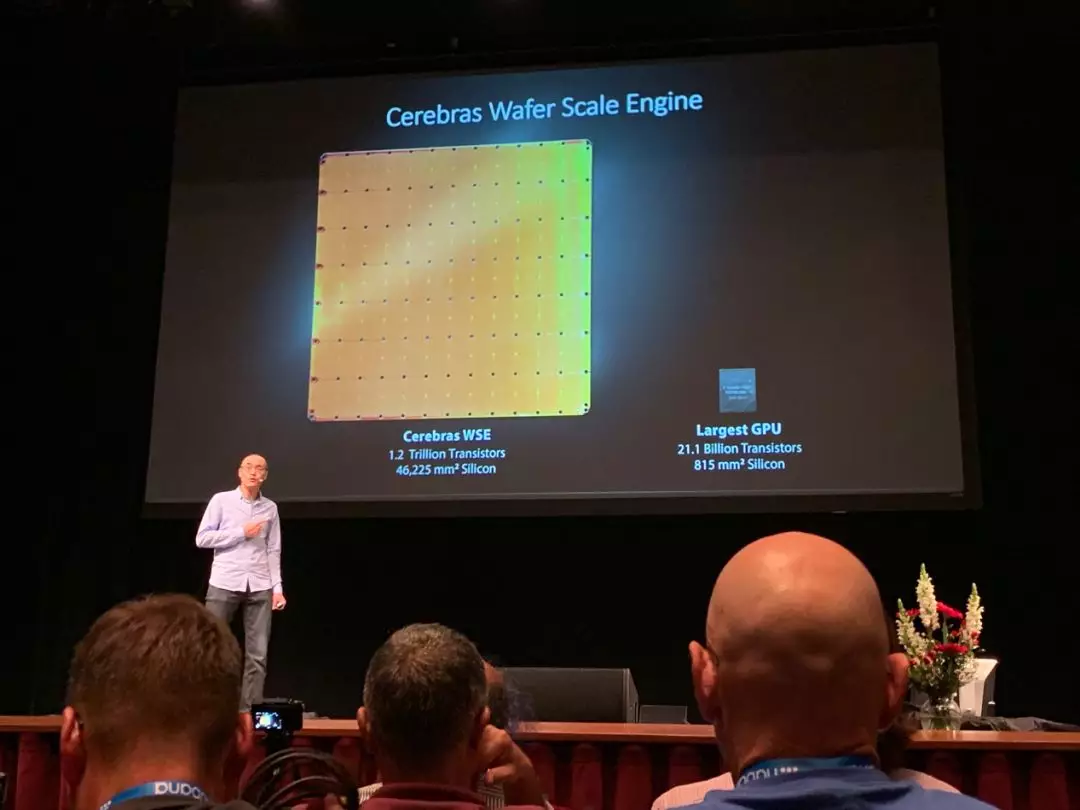

本届Hot Chips最大的亮点,毫无疑问是Cerebras的wafer-scale engine (WSE)。我们通常的芯片,一片wafer可以切出几十到上万片不等的芯片,而为了追求极致的性能、最大的片上存储,Cerebras选择了一条极端的路线,让整片wafer就是一片芯片。当Cerebras的联合创始人Sean Lie拿出样品实物的时候,会场里响起了掌声,这也是本次大会唯一一次不是在报告开始与结束时候礼节性的掌声。

WSE芯片,由12x7=84个die组成,共有40万个为深度学习优化的计算核,片上存储达到了惊人的18GB,超过了很多电脑的内存大小。这样一颗芯片,在我眼里是有特殊的美感的:如同看到长城和金字塔,这样在技术水平极其低下时,似乎人类无法实现的杰作;也如同看到了蒸汽朋克电影中的庞然大物,复古而雄伟;又如同最为精密和复杂的机械表,无数精巧的结构让人感叹。这是在大的范式没有改变的情况,当前工程技术可以做到的极限了。

Cerebras的报告是极少数全篇没有任何性能数字的报告,只有一句话“It’s working”。这样一篇论文能够被Hot Chips录用来进行报告,足见其受到的关注和重视。而我个人有一个习惯,除了认真听别人说做了什么,更会去想他们没说什么。而在这次,他们只说了“It’s working”,而并没有说“It’s working well”,也许就是在暗示些什么。

Cerebras的WSE芯片仍然是有非常多待解决的问题的:(1)这样一片芯片,尽管做了很多的容错设计,其良品率怎样,仍然是一个疑问;(2) 传说中15kw甚至50kw的功耗,怎样去实现良好的散热;(3)整个芯片由12x7个die组成,die之间的通信是与台积电联合研发的新型工艺,其效果如何;这样许许多多的问题,都值得追问下去,而在报告现场,尽管PPT上有相关的页来阐述是用怎样的思路来解决,但是Sean基本上是一带而过,没有介绍任何细节,这也不由得不让人猜测,在这些地方,可能仍然存在着非常多的技术问题需要解决。

对于我个人来说,我非常佩服Cerebras的CEO Andrew Feldman这样一位有魄力、有远见的成功的连续创业者:他曾经做过四个公司,都以上市或者并购成功退出。我也非常佩服包括Sean Lie在内的Cerebras的工程师,勇于挑战最极致的技术路线。任何一条技术路线走通都非常不容易,希望Cerebras能够一个一个解决路上的技术难题,这不仅仅是Cerebras一家公司的事情,也是所有有技术信仰的芯片行业工程师与研究者的共同心声——大家没有机会和财力去做这样一件激动人心的事情,希望你们能做好!

No.2:AI芯片从火热到理性

Cerebras是本次报告最大的亮点,也是被大家关注最多的“AI芯片”的代表。然而,实际上本次大会,AI芯片的设计本身,已经不是被大家关注的重点了——更进一步说,实际上从2017年到现在的两年间,纯数字电路的AI芯片的发展已经几乎停滞了,除了sparsity和low-bit(比如1bit网络,或者tenary网络),在AI芯片,很少听到新的题材了。

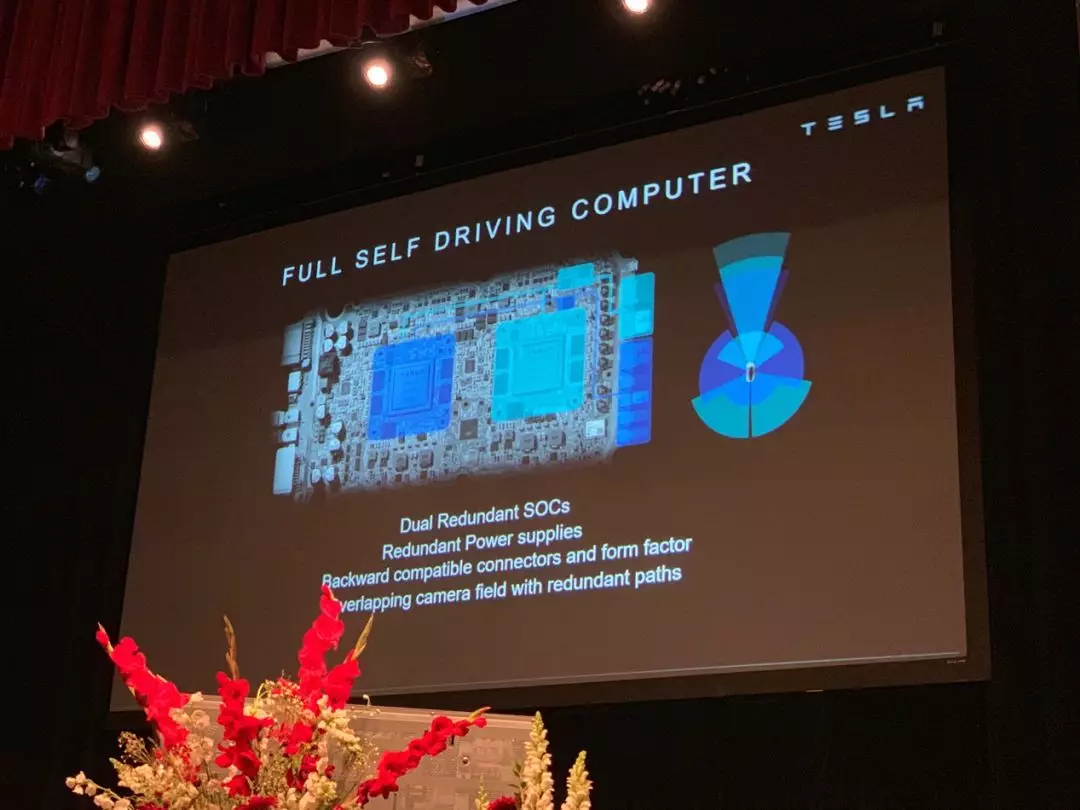

本次大会特斯拉的报告,也充分体现了这一点:许多人最开始对于特斯拉的报告“Compute and redundancy solution for Tesla’s Full Self driving computer”充满期待,因为这是少有的可能能介绍完整自动驾驶系统设计的报告,而结果却令人失望:整个报告花了80%的时间,在介绍底层架构怎样设计,卷积计算的流程如何,指令集如何设计,pooling单元如何设计,而在介绍这些设计的时候,许多抬头听报告的人,都将视线转向了笔记本电脑或者手机。另一个更直观的体现是,在报告结束后的Q&A环节,提问者的问题都在关注在自动驾驶系统中,两片特斯拉自动驾驶芯片是如何配合的,如果真的发生了错误,是如何进行纠错的,而没有人再去拘泥于底层架构设计。

此次Hot Chips仍然有不少“AI芯片”的报告,阿里,华为,Cerebras,Habana(一家以色列不错的创业公司),Tesla,nVidia,Xilinx,Intel,Princeton,然而,每一项工作都是在底层架构设计之外,还有更大的亮点:

阿里实现的应用是少见的text-to-speech,从文本到声音合成,而不是传统的CNN和LSTM加速;华为的达芬奇芯片做了logic die与HBM的直接堆叠,而不是传统高带宽芯片的2.5D interposer的模式,Cerebras芯片是最极端的wafer-scale芯片,Tesla是带有冗余设计的自动驾驶系统,nVidia是NoC+NoP的可扩展架构,Xilinx是全新的Versal芯片与拥有更多可编程性的AI engine一起,Princeton的研究工作是用SRAM做in-memory computing。

此次Hot Chips大会的情况也充分说明,AI芯片的技术噱头时代已经过去,越来越多的人在考虑,怎样去改变当前的范式,用更新的底层技术去实现更好的性能;是否能够真的做出可量产的芯片,之后怎样去和应用更好的融合,实现一个整体好用的系统。在单纯数字芯片模式下,单纯新的体系结构的创新,已经无法带来任何新的机会了——我们必须进一步向前看。

文章转载自:Xilinx学术合作