前几年讲故事,不带上XR混合现实、区块链、元宇宙什么的,你都不好意思和人打招呼。如今,AI也是同样的待遇。

不过,不像前边几个更多是停留在概念性,缺乏群众基础,有的甚至隐约有些“诈骗”的味道,AI其实有着悠久的历史,有着很现实、很广泛的技术和应用,更有着真正广阔的未来,就像曾经的科幻正在一步一步走入现实。

2023年3月的Adobe峰会期间,AMD首席执行官苏姿丰博士在和Adobe首席执行官Shantanu Narayen进行对话时,她提出,未来10年,最重要的事情就是AI,它甚至可以主导芯片设计。

其实早在1956年,人工智能(Artificial Intelligence)的概念就诞生了,算下来已有长达67年的历史。

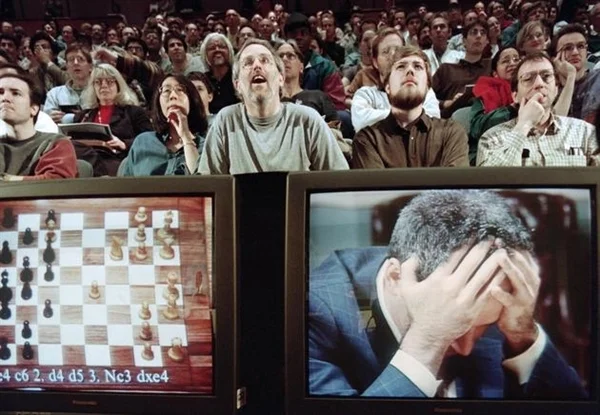

不过直到1997年,IBM公司的“深蓝”电脑击败国际象棋大师卡斯帕罗夫,才让AI的概念广为人知,被视为世界三大尖端技术之一(另两个是空间技术、能源技术),也被认为是21世纪三大尖端技术之一(另两个是基因工程、纳米科学)。

2016-2017年,Google AlphaGo与李世石、柯洁等高手的围棋大战,将AI推向了一个新的高度。

2022年11月,OpenAI ChatGPT的诞生,更是让AI走向了全民化。

自诞生以来,AI的追求始终都是用机器模拟甚至超越人类智能,无论用什么方法、什么技术,这一终极目标从未改变。

幸运的是,经过半个多世纪的演进,半导体技术已经达到了空前的高度,无论算力性能还是算法应用,都给了AI无限的可能。

实现这些可能的根基,毫无疑问是强大的硬件,否则一切都是建筑在沙丘之上。

能够运算AI的硬件多种多样,可以分为两大类。

一是传统的是CPU处理器,好处是通用性强,什么都能做,尤其擅长逻辑控制与串行计算,缺点就是计算能力和针对性不够强。

二就是加速卡,又分为三类,其中GPU适合大量重复计算;FPGA灵活性好,集成度高,但是算力一般,成本高;ASIC专用性强,但开发周期长,难度极高。

今年6月份的“数据中心与人工智能技术首映会”上,AMD给出的数据显示,仅仅是在数据中心, AI加速器的市场价值在2023年就有约300亿美元,预计到2027年可超过1500亿美元,年复合增长率超过50%,妥妥的蓝海。

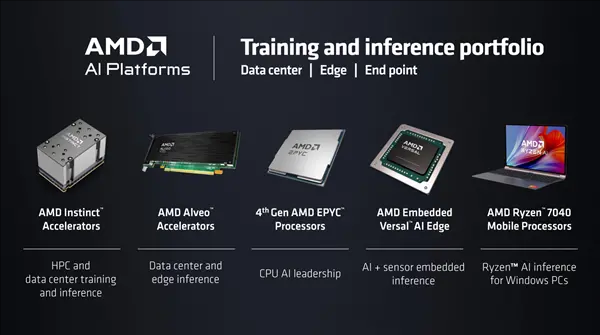

目前,Intel、AMD、NVIDIA三巨头都有各自丰富的AI软硬件解决方案,CPU、GPU可以做,但又各自不同。

Intel CPU历史悠久,一直有领导地位,但近些年遭遇重大挑战,GPU则刚刚起步。

NVIDIA GPU执行业牛耳,优势很大,但是CPU受到极大限制,只能走ARM架构。

AMD则一直是综合性最强的,以往被戏称“GPU吊打Intel、CPU吊打NVIDIA”,如今更是在CPU方面各种欺负Intel,GPU也在奋起直追、不断创新,此外,现在AMD还拥有丰富的FPGA和自适应SoC产品系列供选择。

更进一步,不仅仅在数据中心,AMD在消费端的AI也崭露头角,锐龙7040系列就是全球首款集成独立AI引擎的处理器,开启了AI笔记本的时代。

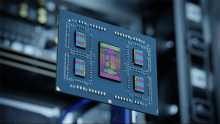

AMD GPU AI加速器就是Instinct系列,经过多年迭代已经发展得极为成熟,在技术上某些方面更是遥遥领先。

比如最新的Instinct MI300A是全球第一款面向HPC、AI的APU加速器,同时集成CDNA 3架构的GPU、Zen 4架构的CPU、128GB HBM3高带宽内存。MI300X更是整合了史无前例的192GB HBM3内存,晶体管数量多达1530亿个,令人叹为观止。同时,AMD ROCm开发平台也正进行改革,针对AI进行全方位深度优化。

GPU做AI如此强悍,已经是很多企业、开发者的首选,你也应该听说过“GPU彻底取代CPU地位”之类的言论,但其实这都是宣传套路而已,听听就行了,切莫认真。

不然的话,NVIDIA为啥还要做个Grace CPU来搭档自家GPU,还号称“超级芯片”?

CPU、GPU、FPGA、ASIC无论哪一个,在AI面前都无所谓谁好谁坏,关键是在灵活多变的AI需求面前,各自做最适合自己的工作。

打个比方,GPU、FPGA、ASIC就像是具备不同特殊技能的特种兵,在某项工作上可以做得非常好,CPU则像是核心领导,只有在它的协调指挥下,才能形成强大的整体战斗力,否则只是一盘散沙而已。

因此,如果非要给大家排个序,CPU反而更有资格排在前列。

这也正是AMD的核心优势,一方面有着极为完整、久经考验的完整产品线和综合平台,另一方面其EPYC CPU处理器近些年更是意气风发,甚至大有完全不把Intel至强放在眼里的架势。

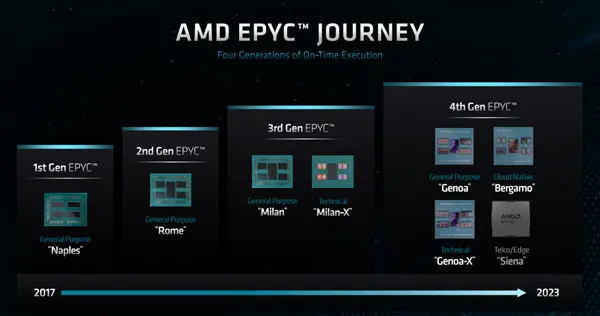

EPYC堪称AMD历史上最成功的产品之一,每一代都极为闪耀,甚至可以说是一直遥遥领先。

2017年,随着基于初代Zen架构、代号Naples的第一代EPYC 7001系列的诞生,AMD终于重返高性能计算市场,得到了整个行业的热烈欢迎。

第三代Milan EPYC首次延伸除了专门针对高密度计算需求的Milan-X,通过堆叠3D V-Cache缓存,得到了数倍的性能提升,在业内是独一无二的存在。

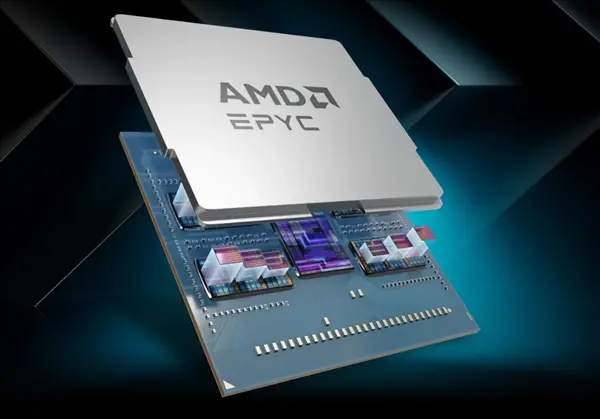

最新的第四代Genoa EPYC 9004系列,更是多点开花,从通用计算到高密度计算,从云服务到边缘计算,再到AI,几乎无所不能。

其中,标准版的Genoa升级到先进的5nm工艺、Zen 4架构,凭借成熟的Chiplet布局,做到最多96核心192线程,还有12通道DDR5内存、160条PCIe 5.0总线的强力加持。

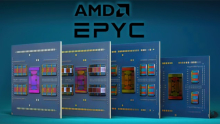

同时,为了满足更多应用领域的特定需求,这一代的EPYC极大地丰富了产品线,除了标准版之外还衍生出了三个特殊系列:

一是Genoa-X EPYC 9084X系列,加入了极为成功的3D V-Cache,是世界上首个采用3D芯片堆叠缓存的数据中心处理器,最多达768MB,加上原生的256MB,三级缓存就有1152MB,再算上6MB一级缓存、96MB二级缓存,总计就是海量的1254MB。

对于需要极强计算性能的应用,Genoa-X是绝对的大杀器,可以轻松获得数倍的性能提升,对手根本看不见尾灯。

二是Bergamo EPYC 9704系列,首次采用精简版的Zen 4c架构,单个核心面积相比标准的Zen 4缩小了大约35%,同时能效大大提升,可以做到遥遥领先的128核心256线程,而且同样有12通道DDR5、160条PCIe 5.0,是云原生计算领域的上佳之选。

三是即将发布的Siena系列,也是Zen 4c架构,据此前信息了解其是专为边缘计算等应用打造,能效同样非常高。

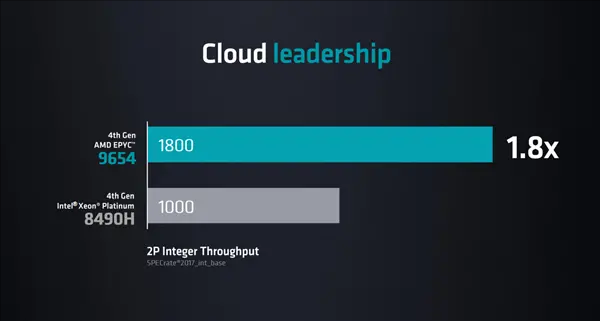

彪悍的规格带来了彪悍的性能,这一次,AMD EPYC在各种应用场景中都有着显著的领先优势。

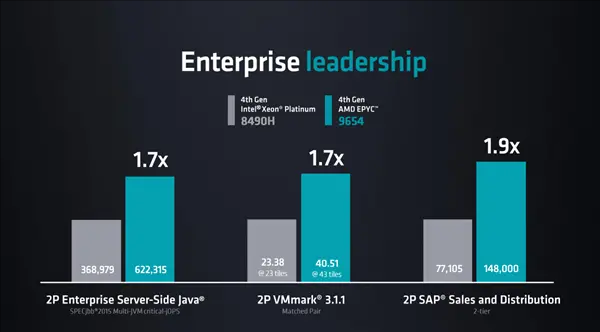

根据官方数据,96核心的旗舰Genoa EPYC 9654对比60核心的竞品旗舰至强铂金8490H,无论是SPECrate2017_int为代表的云服务应用中,还是Java、VMmark、SAP等企业级应用中,性能差异都达到了1.8倍左右,可以说直接甩开了一个身位,根本不给追赶的空间。

更关键的是,性能非常高的同时,EPYC的能效也非常高,性能优势也达到1.8倍左右。

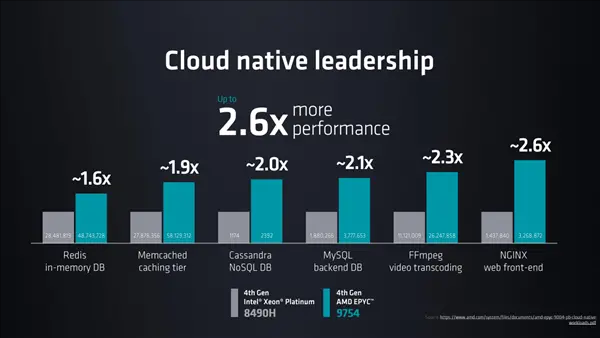

128核心的Bergamo EPYC 9754在云原生应用中,更是近乎蹂躏至强铂金8490H,性能优势更是最高达到惊人的2.6倍。

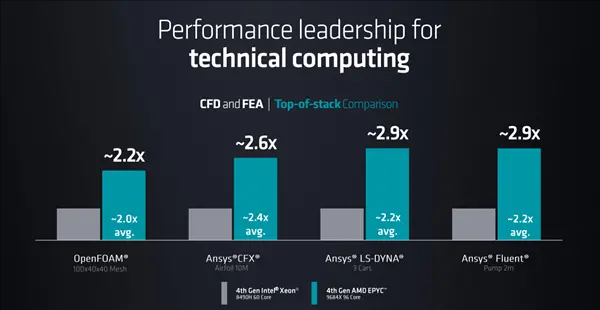

96核心、1152MB三级缓存的Genoa-X EPYC 9684X,在计算性能上的表现也是逆天级别,对比竞品的优势几乎达到了3倍。

目前,戴尔、慧与、联想、超微都已推出基于Genoa-X的高性能计算系统。

当然了,作为AMD AI产品矩阵的一环,EPYC在AI方面的表现同样不遑多让,极强的计算能力带来了极佳的表现。

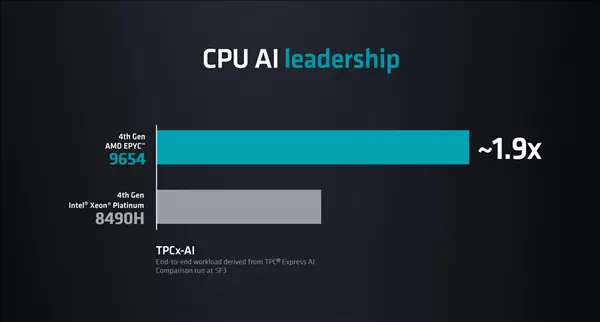

随便举个例子,TPCx-AI端到端负载计算中,EPYC 9654相比于至强铂金8490H的性能优势轻松达到了大约1.9倍之多。

AMD EPYC处理器、Instinct加速器可谓珠联璧合,已经在数据中心、超级计算机中得到了广泛应用。

最典型的就是当今世界第一超算“Frontier”,也是唯一投入实用的百亿亿次超算,用的就是这对黄金组合,其中处理器是Zen 3架构的64核心旗舰EPYC 7A53,加速器则是CDNA 2架构的Instinct MI250X,而且它的绿色能效也是位居前列。

当然了,EPYC、Instinct强强联手的同时,它们也是开放的,完全可以搭档友商的硬件使用,AMD ROCm开发框架同样提供良好的支持。

比如NVIDIA DGX高性能计算平台,就一直在使用顶级的EPYC处理器,可加速多种类型的AI工作负载,例如数据分析、训练和推理等。

任何一个美好的故事,要想持续讲下去,要想变得越来越美好,都必须要有扎实的根基,从硬件到软件再到应用都必须到位才能真正普及开来,MR就是最典型的反面例子。

走过半个多世纪的AI正在焕发新的活力,恰恰就是因为从硬到软,技术和应用都在持续演进,形成了正向循环。

ChatGPT为代表则这一波的爆发,可以说是AI历史上一个新的节点。它最大的贡献就是让AI不再高高在上,而是真正来到了普通老百姓的身边,工作、生活、娱乐都能从中获益匪浅,大大减轻人的压力,可以尽情享受成果。这也正是技术应该带给人的美好之处。

这一切的实现,规格到底,离不开硬件技术的进步、软件生态的成熟、应用领域的丰富。从CPU到GPU,从FPGA到ASIC,都在为AI的繁荣提供扎实的基础,而拥有最全解决方案的AMD,前景尤为值得期许!

本文转载自:快科技