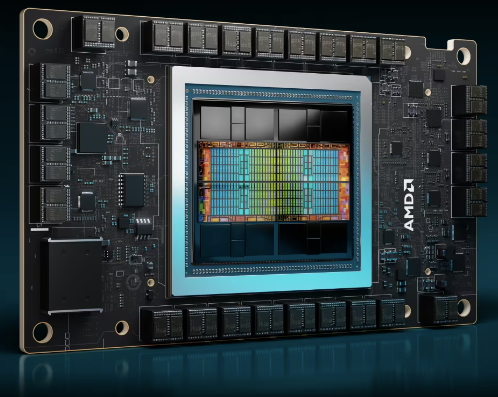

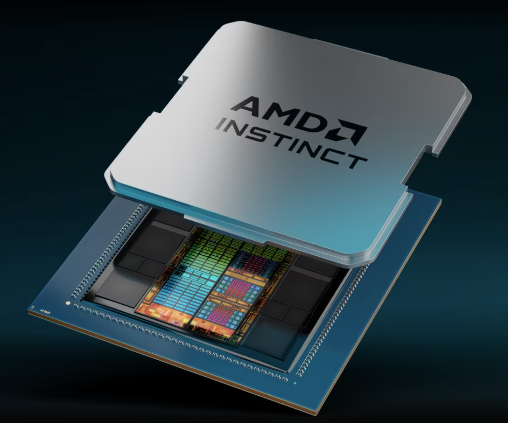

2023 年 12 月 6 日,AMD宣布推出 AMD Instinct™ MI300X 加速器,该加速器具有生成式 AI 行业领先的内存带宽和针对大型语言模型 (LLM) 训练和推理领先的性能。AMD同时也发布了AMD Instinct™ MI300A 加速处理单元 (APU) ,这是一款结合了最新的 AMD CDNA™ 3 架构和“Zen 4”CPU的APU,为 HPC 和 AI 工作负载提供突破性领先性能。

AMD 总裁 Victor Peng 表示:“AMD Instinct MI300 系列加速器采用我们最先进的技术设计,可提供领先的性能,并将用于大规模云和企业部署。” “通过利用我们领先的硬件、软件和开放生态系统,云提供商、OEM 和 ODM 正在将技术推向市场,使企业能够采用和部署人工智能驱动的解决方案。”

AMD Instinct MI300X 加速器由全新 AMD CDNA 3 架构提供支持。与上一代 AMD Instinct MI250X 加速器相比,MI300X 计算单元增加近 40% 、内存容量增加 1.5 倍、峰值理论内存带宽增加 1.7 倍,并支持 FP8 和稀疏性等新数学格式——全部面向 AI 和 HPC 工作负载。

当今大模型的规模和复杂性不断增加,需要大量的内存和计算能力。AMD Instinct MI300X 加速器具有一流的 192 GB HBM3 内存容量以及 5.3 TB/s 峰值内存带宽,可提供日益苛刻的 AI 工作负载所需的性能。

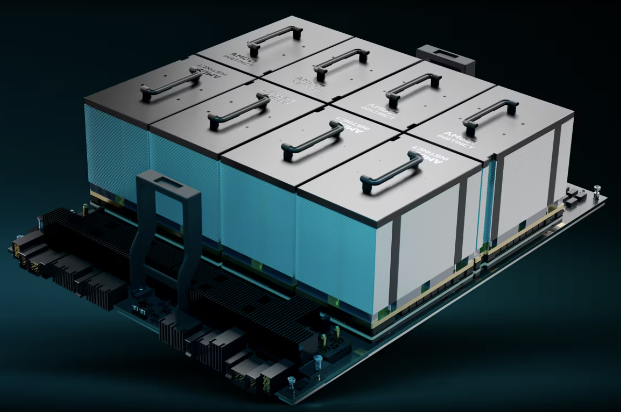

AMD Instinct MI300X 平台

AMD Instinct 平台是领先的生成式 AI 平台,基于行业标准 OCP 设计构建,配备8个 MI300X 加速器,可提供行业领先的 1.5TB HBM3 内存容量。

AMD Instinct 平台的行业标准设计允许 OEM 合作伙伴将 MI300X 加速器设计到现有的 AI 产品中,并简化部署并加速基于 AMD Instinct 加速器的服务器的采用。

与业内其他产品相比,AMD Instinct 平台在 BLOOM 176B等 LLM 上运行推理时,吞吐量可提高高达 1.6 倍,并且在单个 MI300X 加速器上是市场上能够对 Llama2 等 70B 参数模型运行推理的唯一选择,可以简化企业级 LLM 部署并实现出色的 TCO。

AMD Instinct MI300A

AMD Instinct MI300A APU 是全球首款适用于 HPC 和 AI 的数据中心 APU,利用 3D 封装和第四代AMD Infinity 架构,在 HPC 和 AI 融合的关键工作负载上提供领先的性能。

MI300A APU 结合了高性能 AMD CDNA 3 GPU 内核、最新的 AMD“Zen 4”x86 CPU 内核和 128GB 下一代 HBM3 内存。与上一代 AMD Instinct MI250X相比,可在 FP32 HPC 和 AI 工作负载上提供约 1.9 倍的每瓦性能。

能源效率对于 HPC 和 AI 社区至关重要,但这些工作负载是数据和资源极其密集的。AMD Instinct MI300A APU 受益于将 CPU 和 GPU 内核集成在单个封装上,提供高效平台,同时还提供计算性能以加速训练最新的 AI 模型。

AMD 正在以公司的30x25目标引领能源效率创新步伐,旨在从 2020 年至 2025 年将用于人工智能训练和 HPC 的服务器处理器和加速器的能源效率提高 30 倍。

APU 的优势意味着 AMD Instinct MI300A APU 具有统一的内存和缓存资源,为客户提供易于编程的 GPU 平台、高性能计算、快速 AI 训练和令人印象深刻的能源效率,为最苛刻的 HPC 和 AI 工作负载提供支持。

产品参数

人工智能加速器全覆盖:从云端到数据中心

AMD 与多家合作伙伴一起参加了本次发布活动,强调了 AMD Instinct 数据中心人工智能加速器的强劲采用和不断增长的势头。

此外,众多知名数据中心基础设施提供商宣布,计划在其产品组合中集成 AMD Instinct MI300 加速器:

ROCm 软件和生态系统合作伙伴

AMD 宣布推出最新的AMD ROCm 6 开放软件平台,并承诺向开源社区贡献最先进的库,进一步推进公司开源 AI 软件开发的愿景。ROCm 6 软件代表了 AMD 软件工具的重大飞跃,与上一代硬件和软件相比,在 MI300 系列加速器上运行 Llama 2 文本生成时,AI 加速性能提高了约 8 倍。

此外,ROCm 6 还增加了对生成式 AI 的多项新关键功能的支持,包括 FlashAttention、HIPGraph 和 vLLM 等。因此,AMD 拥有独特的优势,可以利用最广泛使用的开源 AI 软件模型、算法和框架(例如 Hugging Face、PyTorch、TensorFlow 等)推动创新、简化 AMD AI 解决方案的部署、释放生成式人工智能的真正潜力。

文章来源:EPYC芯伙伴